Schlagwort: Arktis

-

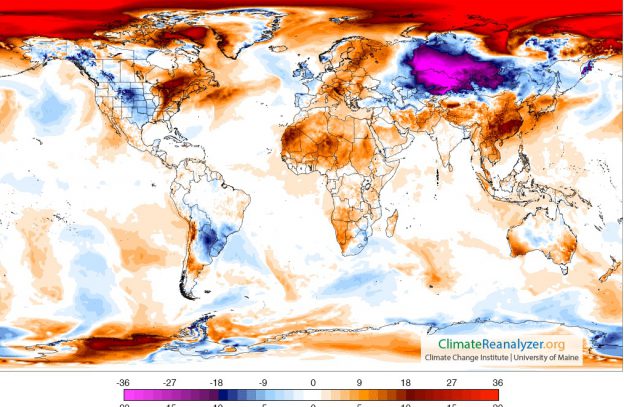

Wettervorhersage für die Arktis

Ein kleiner Blick ganz nach Norden, wo zurzeit erstaunliche Dinge passieren. Sie lassen sich am besten mit einer Reihe von Grafiken erklären. Die erste stammt von der Seite Arctic News: Es ist eine Wettervorhersage für morgen, Samstag den 19.11.2016. Die Polarregion wird demnach gut sieben Grad Celsius wärmer sein als im Durchschnitt der Jahre 1979…

-

Das Zeitalter der Pilzwolken

Am 25. Juli 1946 ließen die Amerikaner auf dem Bikini-Atoll im Rahmen der „Operation Crossroads“ den Sprengsatz Baker 27 Meter unter Wasser detonieren. 93 ausgemusterte und erbeutete Schiffe und viele Versuchstiere wurden der Explosion ausgesetzt. Sie fiel so unerwartet heftig aus und verursachte solche Schäden, dass die Organisatoren den geplanten dritten Test absagten und später…

-

Wo das Meereis bleibt

Auf Spitzbergen hat der Klimawandel kurz der Jahrtausendwende richtig angefangen. Der Osten der Inselgruppe war bis dahin fest im Griff des Meereises. Wenn es dort 15 eisfreie Tage im Jahr gab, war das schon eine Ausnahme; mehr als 50 kamen praktisch nicht vor. Das begann sich in den späten 1990er-Jahren zu ändern: Der Trend der…