Schlagwort: Klimaforschung

-

Der March for Science und das Mittelalter

Am Samstag waren etwa 1500 bis 2000 Menschen auf dem Hamburger Rathausmarkt beim hiesigen March for Science. Es war einer von 600 auf dem ganzen Planeten, die in Solidarität mit dem Protest der amerikanischen Wissenschaftler stattfanden. Diese marschierten in Washington, andere demonstrierten auch in der Antarktis, unter Wasser vor Hawaii und in etwa 20 deutschen Städten, darunter…

-

Aerosole: Problem gelöst?

Das Jungfraujoch in den Berner Alpen beherbergt nicht nur den höchsten Bahnhof Europas, sondern auch das „Sphinx“ genannte Observatorium in 3580 Metern über dem Meeresspiegel. Wenn es sich in Wolken hüllt, wie auf dem Foto, sind vielleicht die Touristen enttäuscht, aber Forscher wie Urs Baltensperger vom Paul-Scherer-Institut in Villigen im Kanton Aargau sind in ihrem…

-

Aerosole: Problem gelöst? Seite 2

Fortsetzung von Seite 1 Aus diesem wissenschaftlichen Erfolg entspinnt sich eine interessante forschungspolitische Diskussion, die ich in meinem SZ-Artikel nur anreiße, und hier vertiefen will. Bjorn Stevens, Direktor am Max-Planck-Institut für Meteorologie in Hamburg, verbindet sein Lob für die Ergebnisse aus der Schweiz mit einer Forderung, die den Autoren der Studien kaum gefallen dürfte. Da…

-

Paris und das Klima – im Großen und Kleinen

Paris geht heute einmal mehr in die Geschichte ein. Unter den Klimavertrag, der dort im vergangenen Herbst ausgehandelt wurde, setzen in New York bei den Vereinten Nationen die ersten Staaten ihre Unterschrift. Das Abkommen soll helfen, die Erwärmung der Welt tatsächlich auf zwei Grad Celsius zu begrenzen, womöglich aber auch auf 1,5 Grad. Der französische…

-

Welche Pause?

„Seepage“, das ist im Englischen ein technischer und geologischer Begriff, der etwas mit Ein- oder Durchsickern zu tun hat. Je nach den beteiligten Flüssigkeiten kann der Vorgang einigermaßen unappetitlich werden, und es ist anzunehmen, dass diese Assoziation Stephan Lewandowsky und Naomi Oreskes ganz willkommen war. Sie haben den Begriff nämlich ins Feld der Wissenschaftsgeschichte übertragen.…

-

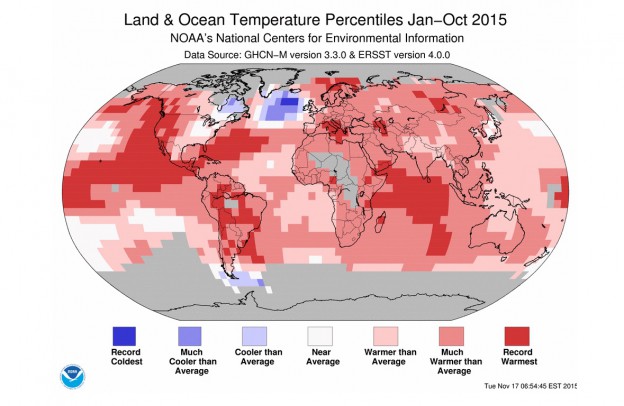

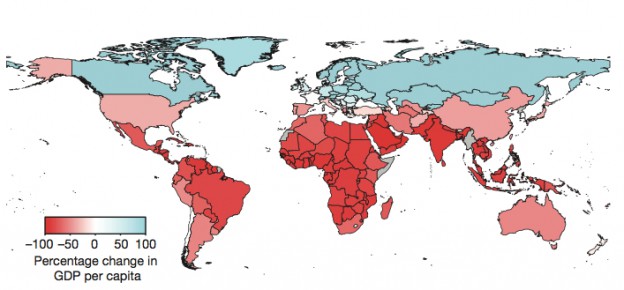

Die Goldlöckchen-Temperatur

Eine Analyse von 166 Ländern zeigt, wie ihre Wirtschaft vermutlich auf den Klimawandel reagieren wird. Entscheidend ist dabei nicht, wie groß das Nationaleinkommen ist, sondern wie hoch die jährliche Durchschnittstemperatur liegt. Jenseits von 13 Grad Celsius bringt die globale Erwärmung auch reichen Nationen Verluste. In Russland, Skandinavien oder Kanada können sich die Menschen eigentlich auf…

-

Der Anfang und eine Erklärung

Laufendes Gut Was ist denn das für ein Titel für einen Blog – Laufendes Gut? Nun, der Begriff kommt aus der Schifffahrt und bezeichnet alles Tauwerk, alle Drahtseile oder Ketten, die nicht an beiden Enden befestigt sind und sich bewegen. Im Gegensatz zum stehenden Gut, das vor allem der Stabilität des Schiffs dient – wie…