Schlagwort: Nature

-

Schonzeit für Riffe

Wenn die Fische zu scheu wurden, gaben ihnen die Dorf-Ältesten eine Auszeit. In der Gemeinschaft der Muluk, wohnhaft an der Ostküste der Insel Karkar in Papua-Neuguinea, stoppten sie die Fischerei über einigen Dutzend Hektar Korallenriffen, wenn die Fänge zu stark zurück gingen. Nach ein oder zwei Jahren, so erzählte man sich in den Dörfern, würden die Fische…

-

Aerosole: Problem gelöst?

Das Jungfraujoch in den Berner Alpen beherbergt nicht nur den höchsten Bahnhof Europas, sondern auch das „Sphinx“ genannte Observatorium in 3580 Metern über dem Meeresspiegel. Wenn es sich in Wolken hüllt, wie auf dem Foto, sind vielleicht die Touristen enttäuscht, aber Forscher wie Urs Baltensperger vom Paul-Scherer-Institut in Villigen im Kanton Aargau sind in ihrem…

-

Aerosole: Problem gelöst? Seite 2

Fortsetzung von Seite 1 Aus diesem wissenschaftlichen Erfolg entspinnt sich eine interessante forschungspolitische Diskussion, die ich in meinem SZ-Artikel nur anreiße, und hier vertiefen will. Bjorn Stevens, Direktor am Max-Planck-Institut für Meteorologie in Hamburg, verbindet sein Lob für die Ergebnisse aus der Schweiz mit einer Forderung, die den Autoren der Studien kaum gefallen dürfte. Da…

-

Wie die Bäume leichter atmen

Die Bäumchen wussten natürlich nicht, wie gut sie es eigentlich hatten. Während sonst überall noch Schnee lag, leuchteten die Setzlinge mit ihren flockenfreien Blättern bereits in vielen Grüntönen um die Wette. Acht Wärmestrahler an einem Gerüst über ihnen versetzten die Pflanzen sozusagen in die Zukunft – in eine Zeit, in der sich die Temperaturen wegen des…

-

Ei-enn-di-ssie

Der einzige Erfolg, den die internationale Gemeinschaft bei ihren Verhandlungen bisher erzielt hat, ist die sogenannte Zwei-Grad-Grenze (und es ist eine Grenze, kein Ziel). Im mexikanischen Cancún, im Jahr 2010, haben die Staaten beschlossen, dass eine Erwärmung bis 2100 gegenüber der vorindustriellen Zeit um diesen Wert gefährlichen Klimawandel darstellt. Und am Anfang des ganzen Prozesses,…

-

Wo das Meereis bleibt

Auf Spitzbergen hat der Klimawandel kurz der Jahrtausendwende richtig angefangen. Der Osten der Inselgruppe war bis dahin fest im Griff des Meereises. Wenn es dort 15 eisfreie Tage im Jahr gab, war das schon eine Ausnahme; mehr als 50 kamen praktisch nicht vor. Das begann sich in den späten 1990er-Jahren zu ändern: Der Trend der…

-

Vorbild Schweiz

In fünf Wochen beginnt in Paris der 21. Klimagipfel der Vereinten Nationen. Die Delegationen aus Europa, China und den USA werden dort vermutlich mit breiter Brust auftreten, und davon schwärmen, was sie alles für den Klimaschutz tun wollen. Insgesamt 154 Staaten haben im Vorfeld der Konferenz ihre nationalen oder regionalen Pläne eingereicht (weil die EU…

-

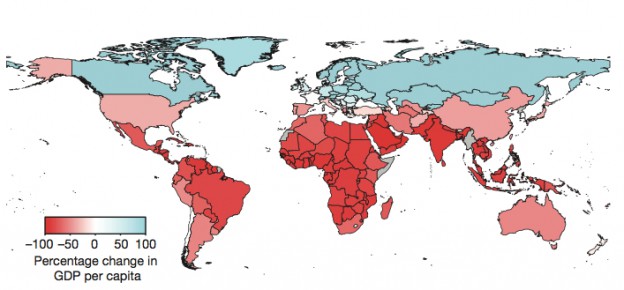

Die Goldlöckchen-Temperatur

Eine Analyse von 166 Ländern zeigt, wie ihre Wirtschaft vermutlich auf den Klimawandel reagieren wird. Entscheidend ist dabei nicht, wie groß das Nationaleinkommen ist, sondern wie hoch die jährliche Durchschnittstemperatur liegt. Jenseits von 13 Grad Celsius bringt die globale Erwärmung auch reichen Nationen Verluste. In Russland, Skandinavien oder Kanada können sich die Menschen eigentlich auf…