Schlagwort: 2016

-

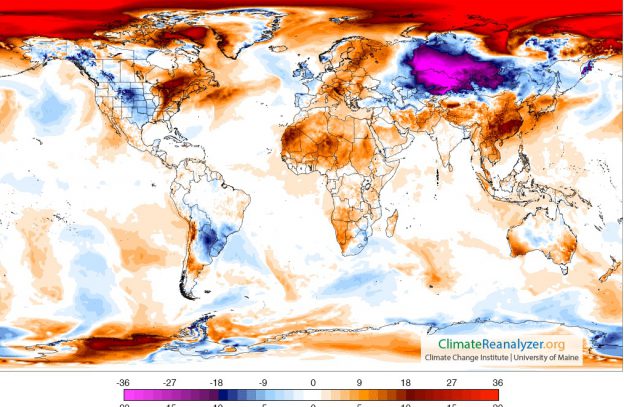

Wettervorhersage für die Arktis

Ein kleiner Blick ganz nach Norden, wo zurzeit erstaunliche Dinge passieren. Sie lassen sich am besten mit einer Reihe von Grafiken erklären. Die erste stammt von der Seite Arctic News: Es ist eine Wettervorhersage für morgen, Samstag den 19.11.2016. Die Polarregion wird demnach gut sieben Grad Celsius wärmer sein als im Durchschnitt der Jahre 1979…

-

Klimatipps – nicht nur für Los Angeles

Zur Abwechslung mal ein paar Klimatipps für Haus und Grundstück. Der erste erreicht uns aus Los Angeles in Kalifornien, wo die vergangenen fünf Jahre der trockenste solche Zeitraum waren, seit das Wetter regelmäßig registriert wird – also seit 140 Jahren. Mehr noch: Eine Dürre wie 2012 bis 2014 sollte nur alle knapp 10 000 Jahre einmal…

-

Das Zeitalter der Pilzwolken

Am 25. Juli 1946 ließen die Amerikaner auf dem Bikini-Atoll im Rahmen der „Operation Crossroads“ den Sprengsatz Baker 27 Meter unter Wasser detonieren. 93 ausgemusterte und erbeutete Schiffe und viele Versuchstiere wurden der Explosion ausgesetzt. Sie fiel so unerwartet heftig aus und verursachte solche Schäden, dass die Organisatoren den geplanten dritten Test absagten und später…

-

Schonzeit für Riffe

Wenn die Fische zu scheu wurden, gaben ihnen die Dorf-Ältesten eine Auszeit. In der Gemeinschaft der Muluk, wohnhaft an der Ostküste der Insel Karkar in Papua-Neuguinea, stoppten sie die Fischerei über einigen Dutzend Hektar Korallenriffen, wenn die Fänge zu stark zurück gingen. Nach ein oder zwei Jahren, so erzählte man sich in den Dörfern, würden die Fische…

-

Aerosole: Problem gelöst?

Das Jungfraujoch in den Berner Alpen beherbergt nicht nur den höchsten Bahnhof Europas, sondern auch das „Sphinx“ genannte Observatorium in 3580 Metern über dem Meeresspiegel. Wenn es sich in Wolken hüllt, wie auf dem Foto, sind vielleicht die Touristen enttäuscht, aber Forscher wie Urs Baltensperger vom Paul-Scherer-Institut in Villigen im Kanton Aargau sind in ihrem…

-

Paris und das Klima – im Großen und Kleinen

Paris geht heute einmal mehr in die Geschichte ein. Unter den Klimavertrag, der dort im vergangenen Herbst ausgehandelt wurde, setzen in New York bei den Vereinten Nationen die ersten Staaten ihre Unterschrift. Das Abkommen soll helfen, die Erwärmung der Welt tatsächlich auf zwei Grad Celsius zu begrenzen, womöglich aber auch auf 1,5 Grad. Der französische…

-

Wie die Bäume leichter atmen

Die Bäumchen wussten natürlich nicht, wie gut sie es eigentlich hatten. Während sonst überall noch Schnee lag, leuchteten die Setzlinge mit ihren flockenfreien Blättern bereits in vielen Grüntönen um die Wette. Acht Wärmestrahler an einem Gerüst über ihnen versetzten die Pflanzen sozusagen in die Zukunft – in eine Zeit, in der sich die Temperaturen wegen des…